mardi 1 novembre 2011

Un robot capable d’apprendre

Le robot Icub est le fruit de 5 années de recherches entre plusieurs universités européennes. Il est actuelement en phase d’apprentissage au laboratoire de l’INSERM de Lyon. En apprentissage car il s’agit là d’un robot auquel des facultés cognitives ont été apportées.

Son intelligence évoluerait du niveau de celle d’un bébé de 18 mois à celle d’un enfant de 3 ans. Capable dans un premier temps d’éxecuter les ordres qu’on lui donne (par exemple pour monter une simple table), il observe et analyse les différentes étapes, les mouvements réalisés, les ordres donnés. Dans un second temps il en vient à anticiper sur les ordres pour finalement prendre les initiatives.

Cet apprentissage est un choix, les chercheurs ont préféré donner au robot une capacité d’apprentissage plutôt que de lui donner un très large éventail d’actions pré-établies. De cette façon le robot se trouve moins limité. Cette faculté a été développée avec des psychologues pour jeunes enfants en copiant leur mode d’apprentissage. Nos robots sont donc maintenant capables d’apprendre, et il faut penser qu’à partir du moment où ils peuvent apprendre quelque chose, ils deviennent aussi capables d’enseigner ce qu’ils ont appris. On pourrait alors imaginer un robot enseignant à ses congénères.

“Le robot exerce des actions automatiquement, sans réfléchir et sans se poser de questions, affirme Peter Ford Dominey. Le but est de le rendre conscient de la finalité de ses actions“.

Un robot ayant conscience des buts à atteindre serait incontestablement beaucoup plus efficace que ceux qui s’éxecutent sans avoir conscience de la fin de leur action. Savoir qu’un but est à atteindre permetrait une plus grande autonomie. Cependant, nous pouvons nous demander comment une telle chose est possible et si le but d’un robot serait du même genre que le but d’un humain. Par exemple avoir conscience que le but de nos actions est d’aider une personne âgée à porter ses courses, nécessite que l’on ait compris le concept d’aide et que l’on ne fasse pas des actions pré-programmées comme saisir le sac, avancer jusqu’à l’endroit prévu, poser le sac etc. Il est raisonnable de penser que la fin du robot se limitera simplement à aller poser le sac à l’endroit prévu ou désigné.

Source : www.gerontechnologie.net

La robotique pour palier aux déficiences physiques et motrices

Que ce soit par accident ou simplement par l’effet de l’âge, de nombreuses personnes sont victimes d’une perte de motricité ou de l’usage d’un membre.

Plusieurs technologies sont développées, du robot rééducateur à la prothèse robotique pour les bras, d’une « orthèse fonctionnelle » à un fauteuil roulant dirigé par la pensée pour les jambes.

Armin est un robot développé par l’école polytechnique de Zurich, il permet aux patients devenus hémiplégiques à la suite d’une attaque cérébrale de faire une rééducation approfondie du bras du malade. “Il aide le patient à reproduire exactement le même mouvement, ainsi le cerveau l’enregistre plus facilement et le réapprentissage est plus aisé“, explique Anja Kollam, ergothérapeute.

Pour les cas plus grave de perte physique d’un membre, une prothèse de bras controlée et alimentée par la pensée a été conçu par Otto Bock healthcare Product GmbH en collaboration avec l’AKH (hôpital central de Vienne) et l’université de médecine de Vienne.

Cette prothèse est dite « intelligente » car ses mouvements sont controlés par les nerfs en charge de déplacer le bras. Cela nécessite une délicate opération chirurgicale pour raccorder les nerfs aux capteurs. Une fois en place ce nouveau bras permet 7 degrés de liberté et une commande intuitive de la prothèse.

Une nouvelle méthode s’appuyant sur la robotique permettrait de faire remarcher les paraplégiques. Elle est développée par l’EPFL (Ecole polytechnique Federale de Lausanne). Le système procède en trois étapes, la première consiste à remuscler les jambes au moyen d’électrodes et à réapprendre les schéma moteurs de la marche en position assise. Pour cela le robot guide le geste de manière ultra-précise et réajuste en permanence les stimulations des électrodes sur les muscles. Utiliser les muscles comme élément moteur est un principe phare de cette méthode dont le but « n’est surtout pas de créer un robocop ». La seconde étape consiste à réapprendre la marche debout au moyen d’un déambulateur robotique travaillant encore avec des électrodes. Enfin, un dispositif très léger est fixé sur les jambes et au bas du dos. Il se dissimule sous un pantalon et permet à la personne de remarcher. Ce serait le cas pour 80% des personnes en fauteuil dont la moelle épinière n’est touchée que partiellement. Ici encore c’est la précision du mouvement permise par le robot lors de la rééducation qui permet ce succès.

Pour les personnes dont la perte de mobilité ne se limite pas aux jambes et qui de ce fait ne peuvent utiliser un joystick pour manoeuvrer un fauteuil, une équipe de recherche espagnole a mis au point un fauteuil dirigeable par la pensée. La méthode est non-invasive puisqu’il s’agit de porter un bonnet contenant seize électrodes qui vont via un électro-ancéphalogramme détecter les fluctuations électriques du cerveau. Lorsque le regard se fixe sur un point précis, elles analysent ses fluctuations et dirigent le fauteuil vers ce point. Il est dit intelligent car contrairement à d’autres prototypes, la personne n’a pas à se concentrer continuellement, et il peut de lui même éviter les obstacles sur son passage.

Plus proche des problématiques directement liées à l’âge, le projet Monimad consiste à développer un déambulateur motorisé et intelligent. “Selon les médecins, de nombreuses personnes âgées, hospitalisées ou non en centre de soin et actuellement immobilisées, pourraient se déplacer de manière autonome si on leur offrait des déambulateurs (ou cadres de marche) plus adaptés à leurs pathologies” , observe Viviane Pasqui, du Laboratoire de Robotique de Paris (Université Paris 6 – CNRS), à Fontenay-aux-Roses.

En effet mis à part les difficultés d’utilisation des déambulateurs traditionnels, aucun d’entre eux ne permet de passer de la station assise à la station debout sans l’aide d’une aide soignante. Monimad est un engin à trois roues conçu pour offrir une autonomie de déplacements des personnes âgées en institut. Il sera capable de baisser ses poignées, afin que le patient assis puisse s’y appuyer de tout son poids, ensuite, l’engin articulé se relèvera, entraînant avec lui le patient ainsi remis debout et prêt à marcher. “A terme, Monimad permettra aussi à son utilisateur d’avancer comme si une personne, attentive à sa progression et à ses difficultés, lui tenait les mains“, commente la chercheuse.

Bardé de capteurs, le déambulateur intelligent tiendra en effet compte de l’attitude de son utilisateur : Si celui-ci pousse les poignées vers l’avant, Monimad avancera, si au contraire les poignées sont tirées vers l’arrière, l’engin freinera automatiquement.

Source : www.gerontechnologie.net

Plusieurs technologies sont développées, du robot rééducateur à la prothèse robotique pour les bras, d’une « orthèse fonctionnelle » à un fauteuil roulant dirigé par la pensée pour les jambes.

Armin est un robot développé par l’école polytechnique de Zurich, il permet aux patients devenus hémiplégiques à la suite d’une attaque cérébrale de faire une rééducation approfondie du bras du malade. “Il aide le patient à reproduire exactement le même mouvement, ainsi le cerveau l’enregistre plus facilement et le réapprentissage est plus aisé“, explique Anja Kollam, ergothérapeute.

Pour les cas plus grave de perte physique d’un membre, une prothèse de bras controlée et alimentée par la pensée a été conçu par Otto Bock healthcare Product GmbH en collaboration avec l’AKH (hôpital central de Vienne) et l’université de médecine de Vienne.

Cette prothèse est dite « intelligente » car ses mouvements sont controlés par les nerfs en charge de déplacer le bras. Cela nécessite une délicate opération chirurgicale pour raccorder les nerfs aux capteurs. Une fois en place ce nouveau bras permet 7 degrés de liberté et une commande intuitive de la prothèse.

Une nouvelle méthode s’appuyant sur la robotique permettrait de faire remarcher les paraplégiques. Elle est développée par l’EPFL (Ecole polytechnique Federale de Lausanne). Le système procède en trois étapes, la première consiste à remuscler les jambes au moyen d’électrodes et à réapprendre les schéma moteurs de la marche en position assise. Pour cela le robot guide le geste de manière ultra-précise et réajuste en permanence les stimulations des électrodes sur les muscles. Utiliser les muscles comme élément moteur est un principe phare de cette méthode dont le but « n’est surtout pas de créer un robocop ». La seconde étape consiste à réapprendre la marche debout au moyen d’un déambulateur robotique travaillant encore avec des électrodes. Enfin, un dispositif très léger est fixé sur les jambes et au bas du dos. Il se dissimule sous un pantalon et permet à la personne de remarcher. Ce serait le cas pour 80% des personnes en fauteuil dont la moelle épinière n’est touchée que partiellement. Ici encore c’est la précision du mouvement permise par le robot lors de la rééducation qui permet ce succès.

Pour les personnes dont la perte de mobilité ne se limite pas aux jambes et qui de ce fait ne peuvent utiliser un joystick pour manoeuvrer un fauteuil, une équipe de recherche espagnole a mis au point un fauteuil dirigeable par la pensée. La méthode est non-invasive puisqu’il s’agit de porter un bonnet contenant seize électrodes qui vont via un électro-ancéphalogramme détecter les fluctuations électriques du cerveau. Lorsque le regard se fixe sur un point précis, elles analysent ses fluctuations et dirigent le fauteuil vers ce point. Il est dit intelligent car contrairement à d’autres prototypes, la personne n’a pas à se concentrer continuellement, et il peut de lui même éviter les obstacles sur son passage.

Plus proche des problématiques directement liées à l’âge, le projet Monimad consiste à développer un déambulateur motorisé et intelligent. “Selon les médecins, de nombreuses personnes âgées, hospitalisées ou non en centre de soin et actuellement immobilisées, pourraient se déplacer de manière autonome si on leur offrait des déambulateurs (ou cadres de marche) plus adaptés à leurs pathologies” , observe Viviane Pasqui, du Laboratoire de Robotique de Paris (Université Paris 6 – CNRS), à Fontenay-aux-Roses.

En effet mis à part les difficultés d’utilisation des déambulateurs traditionnels, aucun d’entre eux ne permet de passer de la station assise à la station debout sans l’aide d’une aide soignante. Monimad est un engin à trois roues conçu pour offrir une autonomie de déplacements des personnes âgées en institut. Il sera capable de baisser ses poignées, afin que le patient assis puisse s’y appuyer de tout son poids, ensuite, l’engin articulé se relèvera, entraînant avec lui le patient ainsi remis debout et prêt à marcher. “A terme, Monimad permettra aussi à son utilisateur d’avancer comme si une personne, attentive à sa progression et à ses difficultés, lui tenait les mains“, commente la chercheuse.

Bardé de capteurs, le déambulateur intelligent tiendra en effet compte de l’attitude de son utilisateur : Si celui-ci pousse les poignées vers l’avant, Monimad avancera, si au contraire les poignées sont tirées vers l’arrière, l’engin freinera automatiquement.

Source : www.gerontechnologie.net

CompanionAble, un projet robotique européen dédié au grand âge

Les différents pays et industriels européens ont mis en commun leurs compétences dans un projet complexe : CompanionAble.

Il ne s’agit pas uniquement d’un robot, mais d’un concept complet de smart home auquel le robot sera relié pour permettre le maintien à domicile des personnes âgées.

Cette technologie peut être définie comme un ensemble d’instruments dont la maison se voit équipée, on peut par exemple penser à des détecteurs de fumée, de gaz, de chutes, un téléphone adapté etc. Le public visé est exclusivement les personnes âgées souffrantes de troubles cognitifs (MCI pour Mild Cognitive Impairment). Ce qui implique un projet ayant une visée principalement thérapeutique et devant être pensé avec un grand nombre de médecins dans chaque pays.

Une des particularités du projet est d’utiliser pour ces malades la stimulation cognitive sur un support informatique. La personne va pouvoir chez elle entraîner ses capacités intellectuelles et sa mémoire pour en arrêter ou au moins en réduire la perte.

Ce travail qui se faisait auprés des psychologues et ergothérapeutes, pourra grâce à des logiciels se faire au domicile de la personne. Les avantages de ce procédé est que la personne pourra s’exercer plus régulièrement ce qui rendra la thérapie plus efficace. Pour les personnes n’habitant pas à proximité d’un hôpital ou d’un accueil de jour, il n’y aura pas de déplacement à faire, les soins seront donc facilités. Le robot sera également équipé pour permettre la télémédecine, le patient pourra joindre une équipe de soignants par un système de visio-conférence connecté à internet. Cette initiative pourra être prise par le robot dans des situations d’urgence.

La communication est ainsi un des points forts du projet puisque ce n’est pas que le personnel de soin qu’il sera possible de contacter, mais aussi l’ensemble des proches. Cette fonction est prévu pour rendre plus accessible aux personnes MCI l’utilisation des moyens de communications tels que le téléphone, internet etc.

Ainsi, en facilitant le contact, le robot offrira une chance supplémentaire de renforcer les liens intergénérationnels et de lutter contre l’isolement.

Le robot est prévu pour aider la personne et lui restituer une certaine autonomie lui permettant de faire à l’aide du robot certaines choses qu’elle ne peut plus faire seule. Les soignants espèrent favoriser ainsi l’estime de soi du malade et limiter les dépressions. Il remplira également la fonction d’aide mémoire et tendra à développer l’intégration sociale de la personne.

Cette collaboration médicale intra-européenne pose néanmoins quelques difficultés. Par exemple la définition d’un patient MCI n’est pas la même en fonction de la nationalité du médecin. Le patient sera diagnostiqué comme souffrants de troubles cognitifs dans un pays alors que pour un autre, le malade aura dépassé ce stade. De plus des questions éthiques se posent autour de ce système concernant l’hyper surveillance du patient qui pourrait être possible.

Source : www.gerontechnologie.net

Les robots de compagnie pour personnes âgées

Le robot a réussi à être inséré dans une relation affective, et c’est dans cet espace que se développent les robots de compagnie.

Notons que l’approche affective par rapport aux robots est un phénomène culturel propre à l’Asie et tout particulièrement au Japon, dont les mangas sont peuplés de robots attendrissants depuis des décennies. La religion est également à l’origine de ce phénomène culturel, alors que le bouddhisme et le shintoïsme, autorisent d’accorder une âme à des objets sans vie.

Non seulement leur utilisation est bénéfique pour le psychisme de la personne âgée, l’aidant à lutter contre le sentiment de solitude et d’isolement. Mais en plus leur popularité s’étend à toutes les classes d’âge.

Tous n’ont pas nécessairement la forme d’un animal, certains ne rappellent rien de vivant, mais ils sont déjà très nombreux. Par exemple ApriAttenda et ApriAlpha de Toshiba, l’un accompli des tâches ménagères, le second fait office de nurse. Capables de reconnaître une personne et de la suivre en restant en retrait. Ils peuvent lire le courrier à voix haute et retrouver une personne dans la foule, de reconnaître les voix, recevoir les ordres, surveiller le domicile…

EMIEW de Hitachi est un robot réceptionniste. Pour ses concepteurs les robots bipèdes sont trop lents actuellement pour pouvoir se rendre utile. Ils en ont donc conçu un qui est monté sur roue lui permettant une vitesse de 6km/h.

Ifbot de Busines Design Laboratory, peut soutenir une conversation grâce à une base de donnée de plusieurs milliers de dialogues, il tient compte des émotions dans la voix de son interlocuteur et peut se souvenir des visages. La capacité à dialoguer reste toujours très limité, on peut même difficilement appeler cela du dialogue. Il s’agit de discussions enregistrés, le robot ne fait que donner la réplique, une phrase entendu correspond à une des phrases enregistrées, le robot répond en répétant la phrase suivante du dialogue.

Mamoru de l’IFF research institute, est destiné aux personnes âgées ou souffrants de troubles cognitifs. Grâce à sa caméra à grand angle, il peut rappeler où se trouvent divers objet (clef, télécommande, tasse, livre, etc) et même rappeler à une personne de prendre ses médicaments.

Twendy-one de Tokyo’s elite waseda university, mesure 1,5m et pèse 111 Kg. Il peut se saisir des objets et les apporter. Il peut par exemple ouvrir un frigo pour prendre de la sauce tomate. Il peut aussi aider les personnes à se lever et à sortir du lit. Il dispose aussi de la faculté de parler. Equipé de multiples capteurs, il peut absorber les chocs en cas de contact avec une personne.

Wakamaru de Mitsubishi, peut également parler, il a un téléphone portable intégré et est branché sur internet via le Wi-fi. Il peut donc appeler les secours si la personne avec qui il est fait un malaise ou une chute.

Il dispose d’une reconnaissance vocale et faciale de ses propriétaires, et peu prendre l’initiative de parler en fonction de ses observations.

Pour finir, Asimo de HONDA, dont le nom est un clin d’oeil au père de la robotique Isaac Asimov.

Asimo est un des robots les plus médiatiques, c’est une véritable vitrine technologique pour la firme japonaise il est par ailleurs considéré comme l’un des robots les plus avancés technologiquement, même si son utilisation nécessite encore le déplacement de plusieurs ingénieurs.

Asimo se destine à différentes tâches allant de l’accueil en entreprise, au coach sportif (comme le robot Taizo le propose déjà) et d’assistance pour séniors jusqu’au maintien à domicile des personnes âgées.

Ces robots de compagnie servent aussi bien à aider qu’à divertir, si bien que la frontière servant à délimiter la robotique d’assistance et celle de confort est extrêmement poreuse. Toutes deux vont souvent de paire et l’on conçoit difficilement une technologie d’aide n’apportant pas un certain confort ou un robot de divertissement n’apportant aucune aide. Cependant il faut reconnaître que ces robots sont encore très lents dans leurs mouvements. De plus leur semblant de conversation nous fait davantage penser à une tentative pour singer l’humain qu’à l’apparition de nouveaux interlocuteurs.

Source : www.gerontechnologie.net

Notons que l’approche affective par rapport aux robots est un phénomène culturel propre à l’Asie et tout particulièrement au Japon, dont les mangas sont peuplés de robots attendrissants depuis des décennies. La religion est également à l’origine de ce phénomène culturel, alors que le bouddhisme et le shintoïsme, autorisent d’accorder une âme à des objets sans vie.

Non seulement leur utilisation est bénéfique pour le psychisme de la personne âgée, l’aidant à lutter contre le sentiment de solitude et d’isolement. Mais en plus leur popularité s’étend à toutes les classes d’âge.

Tous n’ont pas nécessairement la forme d’un animal, certains ne rappellent rien de vivant, mais ils sont déjà très nombreux. Par exemple ApriAttenda et ApriAlpha de Toshiba, l’un accompli des tâches ménagères, le second fait office de nurse. Capables de reconnaître une personne et de la suivre en restant en retrait. Ils peuvent lire le courrier à voix haute et retrouver une personne dans la foule, de reconnaître les voix, recevoir les ordres, surveiller le domicile…

EMIEW de Hitachi est un robot réceptionniste. Pour ses concepteurs les robots bipèdes sont trop lents actuellement pour pouvoir se rendre utile. Ils en ont donc conçu un qui est monté sur roue lui permettant une vitesse de 6km/h.

Ifbot de Busines Design Laboratory, peut soutenir une conversation grâce à une base de donnée de plusieurs milliers de dialogues, il tient compte des émotions dans la voix de son interlocuteur et peut se souvenir des visages. La capacité à dialoguer reste toujours très limité, on peut même difficilement appeler cela du dialogue. Il s’agit de discussions enregistrés, le robot ne fait que donner la réplique, une phrase entendu correspond à une des phrases enregistrées, le robot répond en répétant la phrase suivante du dialogue.

Mamoru de l’IFF research institute, est destiné aux personnes âgées ou souffrants de troubles cognitifs. Grâce à sa caméra à grand angle, il peut rappeler où se trouvent divers objet (clef, télécommande, tasse, livre, etc) et même rappeler à une personne de prendre ses médicaments.

Twendy-one de Tokyo’s elite waseda university, mesure 1,5m et pèse 111 Kg. Il peut se saisir des objets et les apporter. Il peut par exemple ouvrir un frigo pour prendre de la sauce tomate. Il peut aussi aider les personnes à se lever et à sortir du lit. Il dispose aussi de la faculté de parler. Equipé de multiples capteurs, il peut absorber les chocs en cas de contact avec une personne.

Wakamaru de Mitsubishi, peut également parler, il a un téléphone portable intégré et est branché sur internet via le Wi-fi. Il peut donc appeler les secours si la personne avec qui il est fait un malaise ou une chute.

Il dispose d’une reconnaissance vocale et faciale de ses propriétaires, et peu prendre l’initiative de parler en fonction de ses observations.

Pour finir, Asimo de HONDA, dont le nom est un clin d’oeil au père de la robotique Isaac Asimov.

Asimo est un des robots les plus médiatiques, c’est une véritable vitrine technologique pour la firme japonaise il est par ailleurs considéré comme l’un des robots les plus avancés technologiquement, même si son utilisation nécessite encore le déplacement de plusieurs ingénieurs.

Asimo se destine à différentes tâches allant de l’accueil en entreprise, au coach sportif (comme le robot Taizo le propose déjà) et d’assistance pour séniors jusqu’au maintien à domicile des personnes âgées.

Ces robots de compagnie servent aussi bien à aider qu’à divertir, si bien que la frontière servant à délimiter la robotique d’assistance et celle de confort est extrêmement poreuse. Toutes deux vont souvent de paire et l’on conçoit difficilement une technologie d’aide n’apportant pas un certain confort ou un robot de divertissement n’apportant aucune aide. Cependant il faut reconnaître que ces robots sont encore très lents dans leurs mouvements. De plus leur semblant de conversation nous fait davantage penser à une tentative pour singer l’humain qu’à l’apparition de nouveaux interlocuteurs.

Source : www.gerontechnologie.net

La robotique d’aide aux déficiences physiques

Le grand âge engendre moins de pertes cognitives et mnésiques que de pertes physiques.

La masse musculaire s’amoindrit impliquant une diminution des forces du corps. Pour remédier à cela, le Japon a décidé de promouvoir la conception et l’utilisation d’exosquelettes. Ceux-ci sont adaptés pour une utilisation par les personnes souffrantes de déficiences musculaires, ou devant subir un entrainement de réhabilitation physique à titre médical. Il apparait ainsi comme le choix opposé du projet de l’école polytechnique féderale de Lausanne qui a préféré ne pas créer un « robocop », et contrairement au prototype HULC développé en Amérique, il n’est pas prévu à des fins militaires.

HAL (Hybrid Assistive Lymb) a été lancé en 2008 par la société Cyberdyne. Cette combinaison robotique utilise des capteurs placés sur la peau pour détecter les différents mouvements des membres du corps et ainsi multiplier la force de 2 à 10 fois. Alimenté par une batterie d’une autonomie de 2,5 à 5h, cet équipement se vendrait 4.200$ (environ 2.878 euros).

Aujourd’hui HAL a été adapté spécialement pour être utilisé par les personnes âgées. Il est maintenant produit en série et loué à des maisons de repos et hôpitaux. Une démonstration a été organisée dans les rues de tokyo (vidéo ci-après).

Le robot Mobiro d’aide à la mobilité de Toyota a été conçu pour les personnes à mobilité réduite. Il est capable d’atteindre une vitesse de 6 km/h avec une autonomie de 20 km.

L’un de ses avantages est de pouvoir circuler sur des surfaces y compris avec des obstacles sans que la position du passager n’en soit affectée.

Toujours dans le cadre de développement de nouveaux systèmes de transport, Toyota a également mis au point un fauteuil roulant pouvant être contrôlé par la pensée.

L’électroencéphalogramme de l’utilisateur est analysé en quasi-permanence, il suffit donc de penser le mouvement pour que le fauteuil l’exécute, avec un taux de réussite de 95% selon le constructeur.

Source : www.gerontechnologie.net

La masse musculaire s’amoindrit impliquant une diminution des forces du corps. Pour remédier à cela, le Japon a décidé de promouvoir la conception et l’utilisation d’exosquelettes. Ceux-ci sont adaptés pour une utilisation par les personnes souffrantes de déficiences musculaires, ou devant subir un entrainement de réhabilitation physique à titre médical. Il apparait ainsi comme le choix opposé du projet de l’école polytechnique féderale de Lausanne qui a préféré ne pas créer un « robocop », et contrairement au prototype HULC développé en Amérique, il n’est pas prévu à des fins militaires.

HAL (Hybrid Assistive Lymb) a été lancé en 2008 par la société Cyberdyne. Cette combinaison robotique utilise des capteurs placés sur la peau pour détecter les différents mouvements des membres du corps et ainsi multiplier la force de 2 à 10 fois. Alimenté par une batterie d’une autonomie de 2,5 à 5h, cet équipement se vendrait 4.200$ (environ 2.878 euros).

Aujourd’hui HAL a été adapté spécialement pour être utilisé par les personnes âgées. Il est maintenant produit en série et loué à des maisons de repos et hôpitaux. Une démonstration a été organisée dans les rues de tokyo (vidéo ci-après).

Le robot Mobiro d’aide à la mobilité de Toyota a été conçu pour les personnes à mobilité réduite. Il est capable d’atteindre une vitesse de 6 km/h avec une autonomie de 20 km.

L’un de ses avantages est de pouvoir circuler sur des surfaces y compris avec des obstacles sans que la position du passager n’en soit affectée.

Toujours dans le cadre de développement de nouveaux systèmes de transport, Toyota a également mis au point un fauteuil roulant pouvant être contrôlé par la pensée.

L’électroencéphalogramme de l’utilisateur est analysé en quasi-permanence, il suffit donc de penser le mouvement pour que le fauteuil l’exécute, avec un taux de réussite de 95% selon le constructeur.

Source : www.gerontechnologie.net

vendredi 28 octobre 2011

Prospero : Le robot fermier qui va révolutionner l’agriculture

Prospero est un robot en cours de développement qui va permettre de cultiver des champs entier d’une manière autonome. Est ce que cela sera une solution pérenne pour enrayer la crise de nourriture ?

Au fil de l’évolution de l’humanité, l’agriculture a toujours été assisté, que ce soit dans un premier temps avec des animaux, puis des machines. Est ce que les robots fermiers autonomes seront la prochaine évolution de l’agriculture ?

Comme on peut le constater, la production de nourriture croit d’une manière linéaire, tandis que la population humaine croit d’une manière plutôt exponentielle, et tôt ou tard, la demande de nourriture risque d’être supérieure à la production.

Et le point commun de l’agriculture au fil du temps a toujours été l’homme.

C’est donc pour essayer de rendre cette production autonome que Propero a été créé avec 4 phases de développement :

• Phase 1 : Planter des graines.

• Phase 2 : Entretenir la culture.

• Phase 3 : Récolter.

• Phase 4 : Intégrer les 3 phases en un seul robot autonome.

Le robot Propero, n’en ai pour le moment qu’à la phase 1. Ce robot, conçu sur le modèle du robot hexapode Propeller de Parallax, fonctionne en mode essaim, à plusieurs ils couvrent toute une parcelle et discute en eux à l’aide de liaison sans fil.

Chacun scrute le sol pour savoir si une graine n’a pas déjà été planté, puis détermine l’espace optimum pour en planter une à la profondeur encore optimum en fonction de l’état du sol. Il enregistre ensuite précisément cette position afin de pouvoir lui appliquer par la suite (phase 2) différents engrais et insecticide.

Alors, en voyant la vidéo qui suit, on pourrait se croire dans un film de science fiction, et pourtant Prospero fonctionne déjà en mode phase 1.

mardi 25 octobre 2011

Chrysalis- film chorégraphie

À voir aussi le site de Wayne McGregor, son travail sur le rapport au corps est vraiment hors pair (dont Dyad 1929).

«Chrysalis, chorégraphié et interprété par Wayne McGregor et ses danseurs aléatoire est un barrage d'effets spéciaux, le résultat est une mêlée inquiétante du futurisme à un score du même genre que les films d'horreur. McGregor joue le rôle d'un insecte demi, moitié humain de métal-tête plaquée, rampant autour dans un bain, filaire à des dispositifs technologiques futuristes qui semblent nous donner un aperçu de son processus de pensée. Nous sommes pris dans le luminarium de son esprit, où pauvrement vêtu chiffres de danse au milieu des bâches en plastique sale à une cacophonie de sons -. Couinements, drum and base et de sons électroniques, entrecoupées de schémas anatomiques du cerveau humain ».

samedi 22 octobre 2011

mercredi 19 octobre 2011

NANOTOPIA / Michael Burton

Utopia for who?

Nanotechnology promises a utopian vision as a result of our future capability of manipulating the world around us on a nanoscale. As presented by Professor Richard Jones, author of Soft Machines: nanotechnology and life, the true potential of this new technology is when it is fused with organic living systems, like viruses, cellular automata and self-replication.

If our production methods shift to simulate organic self-replication what will happen to the global socio-economic balance? How will the gap between rich and poor be affected? How will people dependent on income from manual production survive?

With these questions as a premise, nanotopia presents a future vision for people at the extremities of the social classes. The project references how people currently use their bodies as a last resort, to sell their hair, blood and kidneys. Nanotopia then envisions a future where the poorest utilise new possibilities of fusing nanotechnology and the body as real-estate. In reaction to this use of the body, the film also visualises the changes in bodily aesthetics within the upper classes.

Source: http://www.michael-burton.co.uk/index2.htm

mardi 18 octobre 2011

Insecte télécommandé

Ce scarabée est un espion. Des électrodes dans son cerveau font de lui un insecte téléguidé.

Source: scienceline.org

Electronic prosthesis / Auger-Loizeau

Electronic Leaf

A wireless communications device is attached to a branch of a tree whilst in leaf, a magnet an led and a battery are connected to the leaf. When the leaf falls the magnetic switch is triggered and the user is informed by a mobile telephone message that the leaf has fallen. The led is activated so that the user may distinguish the leaf should it lands in a pile or blow away.

This technological intervention between user and the leaf provides a space where the user through contemplating on the demise of the leaf might find pleasure in celebrating other ‘banalities’.

Source: www.auger-loizeau.com

sixth sense

'SixthSense' is a wearable gestural interface that augments the physical world around us with digital information and lets us use natural hand gestures to interact with that information. By using a camera and a tiny projector mounted in a pendant like wearable device, 'SixthSense' sees what you see and visually augments any surfaces or objects we are interacting with. It projects information onto surfaces, walls, and physical objects around us, and lets us interact with the projected information through natural hand gestures, arm movements, or our interaction with the object itself. 'SixthSense' attempts to free information from its confines by seamlessly integrating it with reality, and thus making the entire world your computer.

'SixthSense' website

SNIFFING OTHERS PROJECT / SUSANA SOARES

Smell augmentation

In humans the vomeronasal organ, used to detect pheromones, regresses as we leave childhood, but if stimulated could become active again. Smell augmentation using a sensory nanoparticles interface stimulates the vomeronasal organ and transmits body odour information, enabling precise pheromone recognition.

Nasal objects start to transform appearance and beauty concepts, Sniffing Others, New organs of perception, prototype.

Nose plugs

Nose plugs

Illustration explaining how sensory interfaces can stimulate vomeronasal organ

Source : http://www.susanasoares.com/

Audio Tooth Implant / Auger-Loizeau

"The Audio Tooth Implant is a radical new concept in personal communication. A miniature audio output device and receiver are implanted into the tooth during routine dental surgery. These offer a form of electronic telepathy as the sound information resonates directly into the consciousness.

The tooth implant consists of 3 separate elements.

• A low frequency receiver (150kHz).

• A piezo electric micro vibration device.

• An electro magnetic micro generator."

Source : http://www.auger-loizeau.com/

Libellés :

4 - Perception augmentée,

5 - Corps connecté

iPot

"iPot" est une bouilloire qui à chaque utilisation envoie un message à un correspondant choisi au préalable, indiquant que la personne est en bonne santé, ou en tout cas, qu’elle utilise sa bouilloire.

Source : www.mimamori.net

samedi 15 octobre 2011

Breathe

Encore à l’état de concept, Breathe est un système de culture aéroponique d’intérieur de format réduit permettant de cultiver soi même radis, salades et autres plants de basilic. Il ne nécessite que très peu d’entretien puisque le principe même de ce type de culture est de se passer de terre. Une fois branché, l’appareil est à même de gérer l’apport en eau et en nutriments via la racine des plants quelle que soit la saison.

vendredi 14 octobre 2011

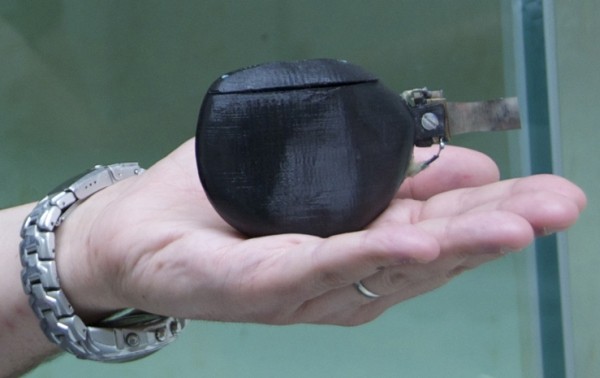

L’idée de Maurizio Porfiri et de son équipe est de faire un poisson robot qui guiderait les autres loin de tout danger humain !

Pour le moment, son invention marche basiquement, et l’équipe compte bien l’améliorer ( la batterie ne dure pas longtemps et le robot ne se déplace que sur un plan en 2 dimension).

Source : Engadget

mardi 11 octobre 2011

Les robots (vraiment) intelligents arrivent.

Article du 11 octobre 2011 sur Europe 1

Des scientifiques japonais ont réussi à «éduquer» des robots qui pensent avant d’agir.

Un robot qui ne se limite pas à réaliser des missions prédéfinies mais qui réfléchit à la manière de ré- soudre un problème. Telle est l’incroyable prouesse de scientifiques japonais, qui ont réussi à éduquer de nouveaux robots. Osamu Hasegawa, professeur agrégé à l’Institut de Technologies de Tokyo, a conçu un système qui permet à un robot humanoïde de voir son environnement et de résoudre les pro- blèmes auxquels il est soudain confronté.

«La plupart des robots existants sont capables d’exé- cuter des tâches préprogrammées, mais ils savent peu de choses sur le monde réel où nous, humains, vivons» explique le chercheur. «Donc, notre projet consiste à construire un pont entre les robots et le monde réel afin qu’ils se comportent mieux au contact des hommes», poursuit-il.

Accumuler des connaissances pour s’en resservir

Son robot est doté d’un «réseau neuronal incrémen- tal auto-organisé» (SOINN), une structure qui lui permet d’accumuler et utiliser des connaissances pour en «déduire» la façon de remplir des tâches données dans un contexte particulier.

Le robot est notamment apte à reconnaître des images et des sons et à reproduire des actions en analysant l’environnement qui l’entoure. Exemple : si vous lui enseignez comment tenir un verre et y verser de l’eau, il saura retrouver ces objets et re- produire cette action dans diverses circonstances, en reconnaissant les objets en question posés au milieu d’autres et en adaptant sa gestuelle au monde qui l’entoure, tout en vérifiant lui-même à chaque étape les résultats de ses actions.

Ce robot, capable de penser avant d’agir, apprend en demandant de l’aide chaque fois qu’il se trouve face à une tâche qui dépasse ses capacités. Après l’apprentissage des nouvelles connaissances re- quises, le robot peut les réutiliser à d’autres fins si nécessaire, ce qui exige là encore réflexion pour juger quelle compétence peut être utile en fonction du problème rencontré.

Savoir se concentrer et surfer sur l’Internet

Comme les humains, le système peut également faire fi du «bruit» ou des informations insignifiantes qui pourraient confondre les autres robots. Le robot sait trier les informations entre celles dignes d’intérêt et celles qui polluent. Autre innovation, le robot est capable de surfer sur Internet pour emmagasiner de nouvelles in- formations. «Nous pourrions demander à un robot de mettre la sauce à sushi sur la table du dîner. Il pourrait dès lors lancer directement une requête d’image de bouteilles de sauce à sushi sur l’inter- net, identifier l’objet et le trouver dans la cuisine», détaille le professeur.

La progression constante des technologies robo- tiques pose toutefois des problèmes d’ordre éthique, reconnaît le scientifique. Selon lui, il nous faut ré- fléchir aux tâches demandées à ces robots «intelli- gents» afin d’éviter que leurs actions ne se retour- nent contre les humains qui les ont créés, comme dans le film «2001: l’Odyssée de l’espace», insiste Osamu Hasegawa.

Source : Reuters

lundi 10 octobre 2011

Hussein Chalayan

"One Hundred and Eleven" Printemps-été 2007

Hussein Chalayan s'est inspiré de la façon dont les événements du monde, y compris les guerres, les révolutions, les changements politiques et sociaux, ont façonné la mode durant un siècle.

Avec One Hundred and Eleven, Chalayan explore le concept du "morphing" et crée une série de robes mécaniques qui se métamorphosent d'un style, d'une époque à l'autre. La bande-son contraste avec la formidable prouesse technologique en rassemblant des fragments audio provenant de réacteurs de jet, d'une guerre des tranchées et de bombardements aériens.

samedi 8 octobre 2011

Electronic Tatoo - Philips

Tattoos and physical mutilation are amongst the oldest forms of personal expression and identity. Subcultures have used tattoos as a form of self representation; a visual language communicating personality and status. Philips Design examined the growing trend of extreme body adornment like tattoos, piercing, implants and scarring.

The Electronics Tattoo film expresses the visual power of sensitive technology applied to the human body. The film subtly leads the viewer through the simultaneous emotional and aesthetic transformations between two lovers.

A voir la vidéo ici

mardi 4 octobre 2011

Plantes nomades

Ce robot nommé Plantas Nomadas a été réalisé par l’artiste mexicain Gilberto Esparza, son objectif : démontrer que l’environnement peut être restauré plutôt que d’être détruit, et cela en toute autonomie.

Un robot écolo totalement autonome grâce à des panneaux solaire et aux bactéries qu’il ingurgite en se promenant dans les rivières et étangs pollués. En effet, grâce à un processus de pile à combustible microbienne, les éléments contenus dans l’eau sont décomposés et transformés en énergie qui alimente ensuite les batteries du robot. L’excédent est ensuite utilisé pour nourrir les plantes qui sont sur sont dos. Un robot infatigable grâce à la pollution…

Source : Plantas Nomadas via Blogbestofrobots

Knock Clock

Knock Clock is a fun little 48-hour project by Gijs Huisman, Giorgio Uboldi, Michael-Owen Liston.

Source : Adafruit Industries

Le dessin mental

Dessiner par la pensée, sans les mains, sans un crayon entre les doigts, mais en engageant son corps d'une autre manière, dessiner avec son esprit, faire surgir des formes visibles ou rêvées par le seul pouvoir de l'imagination, serait-ce donc possible ?

Michel Paysant, dont on peut voir au Louvre l'intérêt pour l'infiniment petit et l'extrêmement grand tels que la science nous permet de les approcher, s'essaie à la galerie Frédéric Giroux (jusqu'au 27 février) à une expérience scientifique d'un tout autre ordre : pendant qu'il regarde un objet, ou, en l'occurence, sa propre image dans un miroir, deux caméras suivent à grande vitesse le mouvement de l'iris de ses yeux pendant 4 longues minutes, mouvement qui est ensuite retranscrit sur papier par de fines lignes de crayon. Là où les lignes sont plus denses, plus nombreuses, c'est que l'oeil s'est reposé plus longtemps; là où la feuille est restée blanche, le regard ne s'est pas attardé. Les angles indiquent les changements abrupts de direction du regard, plus nombreux qu'on ne le croirait. Sans doute faut-il une certaine virtuosité, une certaine gymnastique oculaire consciente pour parvenir à maîtriser suffisamment ses propres mouvements de l'iris afin d'en produire un dessin cohérent : pas de correction possible, et l'incertitude jusqu'à la fin sur la qualité ou non du dessin produit, invisible pendant l'expérience.

Mais le plus intéressant (hélas absent de l'exposition), ce sont les dessins de mémoire : je pense à un être cher ou à un paysage de prédilection, je me le représente mentalement au sens propre, mes yeux le revisitent comme s'il était présent devant moi, et l'apparatus me donne ensuite la trace du dessin que j'ai ainsi "vu" (l'ai-je vu ? recréé visuellement ? rêvé ?). Ce travail sur la représentation de la mémoire par ce procédé scientifique (eyedrawing = oculographie ?) est à la fois fascinant et inquiétant. Je ne sais s'il est promis à un grand avenir, mais il fait rêver, tout en amenant à s'interroger sur la nature même de la vision.

Source : Le Monde du 20 janvier 2010

Augmented contact lens

While many augmented reality application use mobile phones or other interactive devices, university of Washinton professor babak amir parviz and his students want to embed AR technology right into the eye.

Parviz and his students have been working on AR embedded contact lenses that utilize sensors and

wireless technology. right know the technology is in its early days, but researchers hope that one day hundreds of semitransparent LEDs can be embedded onto a thin lens to create a display for users.

This eye implanted display would most likely rely on an external device for controls and processing.

It could be used for entertainment purposes or even to monitor one’s health. next time you go to get your eyes checked at the doctor, they may also be able to offer you the latest contact lens display.

Source : Designboom

Benjamin Grosser : Interactive Robotic Painting Machine

The 'interactive robotic painting machine' by american artist benjamin grosser creates paintings

in response to its aural environment, in a project that investigates the intersections of technology,

consciousness, art, and interaction in today's increasingly technologically mediated society.

during a performance, sound is captured via a microphone and subjected to fourier analysis to be broken down

into useful data for the machine. this information is fed into a genetic algorithm that makes decisions about the painting process,

altering the robot's behaviour in realtime. the functional building blocks of the project are painting 'gestures',

broken down into data such as the amount of pressure to be used in a brush stroke to the amount of paint to add to the brush.

three networked computers manage the painting system the first runs the central control software, written in python,

that begins each painting with a randomly selected set of painting gestures and takes audio data as input

over the course of the painting. a second manages the brush camera and projection, and performs the audio analysis

whose data is sent as input to the first machine. the third computer manipulates the robot itself,

accepting movement commands from the control system and activating stepper motors correspondingly.

the genetic decision-making algorithm behind 'interactive robotic painting machine' means that the painting

is not a direct mapping of what it hears, and that in fact in the presence of the same sound,

would likely create two similar but not identical works.

Source : Benjamin Grosser via Designboom

lundi 26 septembre 2011

vendredi 19 août 2011

Strandbeesten (Theo Jansen)

Theo Jansen est un artiste sculpteur néerlandais du courant de l'art cinétique, qui se base sur l'art du mouvement que ce soit à travers des œuvres mobiles ou des illusions d'optiques.

Ses œuvres sont notamment caractérisées par des sortes d’insectes géants réalisés avec des tubes en plastique, se mouvant grâce à la force du vent

La particularité de son travail est de s'inspirer de la théorie de l'évolution génétique (sélection + reproduction (avec variantes aléatoires) du plus performant) pour guider l'évolution du design de ses sculptures mobiles quasi-autonomes (qu'il nomme "créatures"). La finalité de son travail de recherche semble plus orienté vers des finalités pratiques qu'esthétiques, on peut donc aussi le classer dans la catégorie des ingénieurs/inventeurs.

Sources Strandbeest + Wikipedia

MTRAN3 Modular Robot

Comment, avec un simple module répété à la demande, il est possible de concevoir des ensembles à vocation diverses.

Chaque module dispose d’une autonomie suffisante et ses propres capteurs.

4 leg Wide To Snake M-TRAN II Robot par Tweepy

Source National Institute of Advance Industiral Science and Technology (AIST)

BigDog

BigDog est un robot quadrupède à l'allure de chien créé en 2005 par la société américaine Boston Dynamics. Foster-Miller, le Jet Propulsion Laboratory et la Harvard University Concord Field Station ont également participé à sa création1. Il a été financé par la DARPA, l'agence de recherche du département de la Défense des États-Unis.

BigDog est une sorte de mulet destiné à accompagner les soldats en leur transportant du matériel dans des terrains trop irréguliers pour les véhicules. Il peut également mener des opérations d'observation. Il utilise quatre pattes qui lui permettent de se mouvoir sur un sol impraticable pour des engins ou robots avec des roues. Il mesure 91 cm de long pour 76 cm de haut et pèse 110 kg soit la taille d'une petite mule. Il est capable de traverser un terrain difficile à 6,4 km/h, de porter un chargement de 150 kg et de grimper des pentes de 35°.

Une vidéo diffusée par Boston Dynamics en mars 2008 montre un BigDog capable de se mouvoir dans des terrains enneigés ou verglacés et de se rétablir après avoir été violemment poussé sur le côté.

Son déplacement est contrôlé par un ordinateur embarqué qui reçoit des informations de multiples capteurs de l'engin. La navigation et l'équilibre sont aussi gérés par cet ordinateur.

Sources Wikipedia + Boston Dynamics

Small work for robot and insects (Andie Gracie)

'Small work for robot and insects' has evolved over a period of three years. v1 was a commission from digitalsummer01: inter[face] to produce a small sound based piece of work, and formed part of a series of investigations into interfaces between natural and technological systems. The work consisted of a group of crickets and a simple quadruped robot existing in a large glass tank, seperated by a glass divider. The sound of the cricket song was transmitted to the robot which made a series of random movements in response.

v2 was commissioned by Arnolfini Live and is a much more sophisticated work. A new hexapod robot was designed and built from scratch and a neural network brain was programmed by Brian Lee Yung Rowe of Muxspace, New York. The robot is now able to listen intelligently to the cricket song and attempt to devise a unique language with which to communicate with them or provoke them into certain behaviours.

The work frames an interest in exploring connections between machine and nature that are outside the typical areas covered by cybernetics or purely scientific study. It illustrates the attempts to allow spontaneous relationships to emerge and provide a platform for us to witness the process. By forming a mechanical entity with qualities which are vaguely lifelike but which have the capacity to behave in a completely non-lifelike manner we allow the formation of spontaneous relationships that inhabit a ‘third state’. All parts of the system need to adapt to each other for meaningful communication and exchange to take place, rather than informed response. Once, and if, this third state is achieved the entities can begin a mutual exchange of information which will continually evolve and develop nuance.

The robotic element of the installation is a custom designed and built polycarbonate and aluminium hexapod with the capacity to express itself using movement, lights and sound. It has an initial library of 18 base motions, 7 base light sequences and 32 base sounds which can be considered as 'phonemes', a starting point from which can be extracted any sequence or combination to construct a complex and evolving vocabulary.

The incoming sound from the crickets is analysed using fft processes in max/msp and the resulting numerical data is passed to the neural network. Once the neural network has done its processing it passes back the numerical representation of the ‘sentence’ to max/msp which relays it via serial to the robot. The robot carries an onboard microprocessor (OOPic) loaded with a programme to control its functions, which are triggered by the data coming from the neural network.

Farm Fountain (Ken Rinaldo & Amy Youngs)

Farm Fountain is a system for growing edible and ornamental fish and plants in a constructed, indoor ecosystem. Based on the concept of aquaponics, this hanging garden fountain uses a simple pond pump, along with gravity to flow the nutrients from fish waste through the plant roots. The plants and bacteria in the system serve to cleanse and purify the water for the fish.

This project is an experiment in local, sustainable agriculture and recycling. It utilizes 2-liter plastic soda bottles as planters and continuously recycles the water in the system to create a symbiotic relationship between edible plants, fish and humans. The work creates an indoor healthy environment that also provides oxygen and light to the humans working and moving through the space. The sound of water trickling through the plant containers creates a peaceful, relaxing waterfall. The Koi and Tilapia fish that are part of this project also provide a focus for relaxed viewing.

The plants we are currently growing include lettuces, cilantro, mint, basil, tomatoes, chives, parsley, mizuna, watercress and tatsoi. The Tilapia fish in this work are also edible and are a variety that have been farmed for thousands of years in the Nile delta.

Joyful Trees (Diller & Scofidio + Renfro)

Arbores Laetae – or Joyful Trees – has transformed a former brownfield site as part of the 2008 Liverpool Biennial arts festival.

Designed by New York architects Diller, Scofidio and Renfro, festival bosses say the work gives people a chance to “view nature at its most unnatural”.

The slowly rotating trees, intended to be a playful reinvention of the public park, were largely welcomed by members of the public in their unveiling.

The three rotating trees can found at the heart of 17 hornbeam trees planted in a grid pattern at the corner of Great George Street and Parliament Street, but are not immediately obvious to passing pedestrians or traffic. In place of the familiar movement of shade according to the rotation of the earth around the sun, here shade migrates at an artificial speed, transforming the familiar patterns of the natural world into artificial creations.

Some people find their unfamiliar shading patterns tranquil and others, unsettling, which was the aim, according to designer, Rick Scofidio.

Mr Scofidio told BBC News: “I found that it’s both beautiful, wonderful and a little bit frightening.

“Trees in poems are beautiful objects, but they are also things that tap on your window at night and in many fairy stories are quite evil and dangerous.

Source Music Columbia

Carnivorous Domestic Entertainment Robots (Auger-Loizeau & Alex Zivanovic)

Over the coming years, Robots are destined to play a significant part in our daily existence. The idea of sharing our lives with these artificial entities in their various guises has captured the public imagination for decades.

Robots have represented both our hopes and fears for what the technological future may hold, yet at this time they remain very much an enigma. There is a huge disparity between the profound potential robots exhibit in the realms of science fiction and our imagination; the banal reality of vacuum cleaners, lawnmowers and robotic pet dogs; and the vision of robots as seen through the eyes of computer scientists and engineers.

With this project we propose an alternative perspective on domestic robots, exploring both the aesthetics and functionality that may elicit a symbiotic co-existence with humans in their homes.

To achieve acceptance the robots operate on different levels :

Inspired by natural methods of adaptation, they have shunned the stereotypical look normally associated with robots and adopted a fashionable, contemporary design aesthetic. In this way they operate as exclusive furniture and household accessories.

Utilising the microbial fuel cell as an energy source the robots reference strategies of predatorial insects, reptiles and plants such as the wolf spider, the chameleon and the Venus flytrap and apply these harvesting techniques to the acquisition of food. This gives them autonomy and to a degree they become living entities existing in a similar way to an exotic pet such as a snake or a lizard, where we provide living prey and become voyeurs in a synthesized, contrived microcosm.

We might sit around the objects waiting for the spectacular moment when the prey is captured and slowly transformed into moving energy bars on the graphic displays built into some of the objects.

In this way they provide a dark form of entertainment competing with the spectacle of life seen in television programs such as Big Brother, Wife Swap or edited and dramatised depictions of war. As consumers of these programs, like those who keep vivariums, we have the potential to be repulsed, engaged or both.

They are currently built as a series of five semi-operational prototypes :

Lampshade robot

Flies and moths are naturally attracted to light. This lamp shade has holes based on the form of the pitcher plant enabling access for the insects but no escape. Eventually they expire and fall into the microbial fuel cell underneath. This generates the electricity to power a series of LEDs located at the bottom of the shade. These are activated when the house lights are turned off.

Mousetrap coffe table robot

A mechanised iris is built into the top of a coffee table. This is attached to a infra red motion sensor. Crumbs and food debris left on the table attract mice who gain access to the table top via a hole built into one over size leg. Their motion activates the iris and the mouse falls into the microbial fuel cell housed under the table. This generates the energy to power the iris motor and sensor.

Fly stealing robot

This robot encourages spiders to build their webs within it's armature. Flies that become trapped in the web are tracked by a camera. The robotic arm then moves over the dead fly, picks it up and drops it into the microbial fuel cell. This generates electricity to partially power the camera and robotic arm. This robot also relies on the UV fly killer parasite robot to supplement it's energy needs.

UV fly killer parasite

A microbial fuel cell is housed underneath an ultra violet fly killer. As the flies expire they fall into the fuel cell generating electricity that is stored in the capacitor bank. This energy is available for the fly stealing robot.

Fly-paper robotic clock

This robot uses flypaper on a roller mechanism to entrap insects. As the flypaper passes over a blade, captured insects are scraped into a microbial fuel cell. Electricity is generated to turn the rollers and power a small LCD clock.

Flies and moths are naturally attracted to light. This lamp shade has holes based on the form of the pitcher plant enabling access for the insects but no escape. Eventually they expire and fall into the microbial fuel cell underneath. This generates the electricity to power a series of LEDs located at the bottom of the shade. These are activated when the house lights are turned off.

Mousetrap coffe table robot

A mechanised iris is built into the top of a coffee table. This is attached to a infra red motion sensor. Crumbs and food debris left on the table attract mice who gain access to the table top via a hole built into one over size leg. Their motion activates the iris and the mouse falls into the microbial fuel cell housed under the table. This generates the energy to power the iris motor and sensor.

Fly stealing robot

This robot encourages spiders to build their webs within it's armature. Flies that become trapped in the web are tracked by a camera. The robotic arm then moves over the dead fly, picks it up and drops it into the microbial fuel cell. This generates electricity to partially power the camera and robotic arm. This robot also relies on the UV fly killer parasite robot to supplement it's energy needs.

UV fly killer parasite

A microbial fuel cell is housed underneath an ultra violet fly killer. As the flies expire they fall into the fuel cell generating electricity that is stored in the capacitor bank. This energy is available for the fly stealing robot.

Fly-paper robotic clock

This robot uses flypaper on a roller mechanism to entrap insects. As the flypaper passes over a blade, captured insects are scraped into a microbial fuel cell. Electricity is generated to turn the rollers and power a small LCD clock.

Carnivorous Domestic Entertainment Robots were designed by James Auger, Jimmy Loizeau and Aleksandar Zivanovic. Julian Vincent is director at the Centre for Biomimetics and Natural Technologies, and acted as an advisor to the design process. An initial start point for the project was Ecobot, a fly-eating robot developed at Bristol Robotics Laboratory which uses microbial fuel cells to generate its own power.

Microbial fuel cell kits are available from the National Centre for Biotechnology Education (NCBE) at Reading University.

Source Material Beliefs

Source Material Beliefs

Inscription à :

Articles (Atom)